Variable aléatoire discrète

Généralités

- $X(\Omega)$ est un ensemble au plus dénombrable.

- Pour tout $x\in X(\Omega),\quad X^{-1}(x)= \{\omega\in \Omega,\,X(\omega)\in x\}$ est un événement de $\mathcal{F}$. On note en générale $X^{-1}(x)=(X=x)$.

Lorsque $E=\R$, on parle d'une variable aléatoire discrète

- L'appellation variable aléatoire est pratique!. En effet, $X$ n'est pas une variable, mais bien une fonction. Ce sont les valeurs prises par $X$ qui correspondent à des quantités qui vont varier selon le résultat de l'expérience aléatoire.

- Plus généralement, si $U$ est un sous-ensemble de $X(\Omega)$, $X^{-1}(U) = \{\omega \in \Omega,\, X(\omega) \in U\}$. Le fait d'employer cette notation ne signifie absolument pas que $X$ est bijective !

- Si $X$ est une v.a.d sur $\Omega$ alors on peut écrire $X(\Omega)=\{x_n,\,n\in I\}, \,(I\subset\N)$. Alors la famille $\left( (X=x_n)\right)_{n\in I}$ est un système complet d'événements.

- On tire avec remise $n$ boules dans une urne contenant des boules blanches et rouges en proportion $p$ et $q=1-p$. On note $X$ le nombre de boules blanches obtenues dans un tirage, $X$ est une variable aléatoire discrète à valeurs dans $\inter{0,n}$.

- On effectue une succession de lancers d'un dé jusqu'à obtenir $6$. On note $X$ le nombre de lancers effectués. Alors $X$ est une variable aléatoire discrète.

Il est fréquent de manipuler des v.a.d sans préciser l'espace probabilisé d'étude.

$P_X$ définit une probabilité sur $(X(\Omega),\mathcal{P}(X(\Omega)))$.

Soit X une variable aléatoire dont la loi est donnée par le tableau ci-dessous.

| $x_i$ | -3 | -2 | -1 | 0 | 1 | 2 | 3 |

| $P(X=x_i)$ | 0.10 | 0.10 | 0.20 | 0.25 | 0.15 | 0.15 | 0.05 |

Donner la loi de $X^2$.

Comme $X(\Omega)=\{-3,-2,-1,0,1,2,3\}$ alors les valeurs prises par $X^2$ sont $0,1,4$ et $9$, et on a :

- $P(X^2=0)=P(X=0)=0.25$,

- $P(X^2=1)=P((X=-1)\cup (X=1))=P(X=-1)+P(X=1)=0.15+0.20=0.35$.

- $P(X^2=4)=P((X=-2)\cup (X=2))=P(X=-2)+P(X=2)=0.10+0.15=0.25$.

- $P(X^2=9)=P((X=-3)\cup (X=3))=P(X=-3)+P(X=3)=0.10+0.05=0.15$.

On trouve finalement,

| $x_i$ | 0 | 1 | 4 | 9 |

| $P(X^2=x_i)$ | 0.25 | 0.35 | 0.25 | 0.15 |

On lance une pièce équilibrée consécutivement. On s'arrête dès que deux piles successifs sont apparus. On note $X$ le nombre de lancers jusqu'à l'arrêt. Trouver la loi de $X$, s'agit-il d'une VA?

On note $P_n$ (resp. $F_n$) l'événement : 'On a obtenu pile au $n$ème lancer' (resp. 'On a obtenu face au $n$

èmelancer').

Il est clair, que

$$P(X=1)=0,\quad P(X=2)=P(P_1\cap P_2)=\dfrac{1}{4},\quad P(X=3)=P(F_1\cap P_2\cap

P_3)=\dfrac{1}{8}.$$

Les événements ($F_1,\,P_1\cap P_2,\,P_1\cap F_2)$ forment un système complet, donc, pour

tout $n\geq 3$, on a

$$P(X=n)=P(F_1)P_{F_1}(X=n)+P(P_1\cap P_2)P_{P_1\cap P_2}(X=n)+P(P_1\cap F_2)P_{P_1\cap

F_2}(X=n).$$

Or,

- $P(F_1)P_{F_1}(X=n)=\dfrac{1}{2}P(X=n-1)$, en effet la probabilité d'avoir $X=n$ sachant que la 1 èrelancer est face est la même que $X=n-1$ (tous les lancers sont décalées de $1$).

- $P(P_1\cap P_2)P_{P_1\cap P_2}(X=n)=0$, puisque si on a $(P_1\cap P_2)$ est réalisé alors le jeux s'arrête.

- $P(P_1\cap F_2)P_{P_1\cap F_2}(X=n)=\dfrac{1}{4}P(X=n-2)$.

On en déduit, pour tout $n\geq 2$, $$P(X=n)=\dfrac{2P(X=n-1)+P(X=n-2)}{4}\Longrightarrow P(X=n)=\alpha \left(\frac{1+\sqrt{5}}{4}\right)^n+\beta \left(\frac{1-\sqrt{5}}{4}\right)^n.$$ On trouve, après calcul, $\alpha =\dfrac{\sqrt{5}-1}{2\sqrt{5}},\quad \beta=\dfrac{\sqrt{5}+1}{2\sqrt{5}}$. Ainsi, $$P(X=n)=\dfrac{\sqrt{5}-1}{2\sqrt{5}}\left(\frac{1+\sqrt{5}}{4}\right)^n+\dfrac{\sqrt{5}+1}{2\sqrt{5}} \left(\frac{1-\sqrt{5}}{4}\right)^n.$$ D'autre part, on a $P(X=n)\geq 0$ et $$\begin{array}{lcl} \dsum_{n\geq 1}P(X=n)&=&\dfrac{\sqrt{5}-1}{2\sqrt{5}}\dsum_{n\geq 1}\left(\frac{1+\sqrt{5}}{4}\right)^n+\dfrac{\sqrt{5}+1}{2\sqrt{5}} \dsum_{n\geq 1}\left(\frac{1-\sqrt{5}}{4}\right)^n\\ &&\\ &=&\dfrac{\sqrt{5}-1}{2\sqrt{5}}\left(\dfrac{4}{3-\sqrt{5}}-1\right)+\dfrac{\sqrt{5}+1}{2\sqrt{5}}\left(\dfrac{4}{3+\sqrt{5}}-1\right)\\ &&\\ &=&\dfrac{\sqrt{5}-1}{2\sqrt{5}}\dfrac{1+\sqrt{5}}{3-\sqrt{5}}+\dfrac{\sqrt{5}+1}{2\sqrt{5}}\dfrac{1-\sqrt{5}}{3+\sqrt{5}}=\dfrac{2}{\sqrt{5}}\left(\dfrac{1}{3-\sqrt{5}}-\dfrac{1}{3+\sqrt{5}}\right)\\ &&\\ &=&\dfrac{2}{\sqrt{5}}\dfrac{2\sqrt{5}}{4}=1 \end{array}$$ Donc $X$ est bien une V.A.

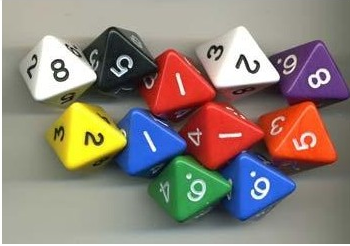

On lance deux dés équilibrés à 8 faces, et on note S la somme des deux résultats qu’on

obtient.

Déterminer la loi de probabilité de $S$ puis calculer $P(S \geq 9)$.

Ici $\Omega =\inter{1,8}$ et $S(\Omega)=\inter{2,16}$. De plus pour $k\in S(\Omega)$, notons $X_1$ (resp. $X_2$) le résultat de 1ère dé (resp. résultat de 2ème dé), on distingue deux cas:

- $k\in \inter{2,9}$, dans ce cas, $$(S=k) = \bigcup_{1\leq i < k}(X_1=i)\cap (X_2=k-i)= \dfrac{k-1}{64}$$

- $k\in \inter{10,16}$, dans ce cas $$(S=k)=\bigcup_{1\leq i\leq 8}(X_1=i)\cap (X_2=k-i)=\bigcup_{k-8\leq i\leq 8}(X_1=i)\cap (X_2=k-i) = \dfrac{17-k}{64}$$

from random import *

def Somme2De(n):

De = [1,2,3,4,5,6,7,8]

global Somme

i = 0

while i < n+1:

i+=1

X1 = choice(De)

X2 = choice(De)

Somme[X1+X2]+=1/n

Somme=[0 for i in range(17)]

ResTh=[0 for i in range(17)]

for i in range(2,10):

ResTh[i]=(i-1)/64

for i in range(10,17):

ResTh[i]=(17-i)/64

Somme2De(10**6)

for i in range(2,17):

print("Somme =%2d, Res theo = %0.6f,Res simu= %0.6f"%(i,ResTh[i],Somme[i]))

Voici les résultats obtenus

Somme = 2, Res theo = 0.015625,Res simu= 0.015457

Somme = 3, Res theo = 0.031250,Res simu= 0.031197

Somme = 4, Res theo = 0.046875,Res simu= 0.046822

Somme = 5, Res theo = 0.062500,Res simu= 0.062373

Somme = 6, Res theo = 0.078125,Res simu= 0.077649

Somme = 7, Res theo = 0.093750,Res simu= 0.093762

Somme = 8, Res theo = 0.109375,Res simu= 0.109487

Somme = 9, Res theo = 0.125000,Res simu= 0.125026

Somme =10, Res theo = 0.109375,Res simu= 0.109250

Somme =11, Res theo = 0.093750,Res simu= 0.093338

Somme =12, Res theo = 0.078125,Res simu= 0.078716

Somme =13, Res theo = 0.062500,Res simu= 0.062848

Somme =14, Res theo = 0.046875,Res simu= 0.047015

Somme =15, Res theo = 0.031250,Res simu= 0.031249

Somme =16, Res theo = 0.015625,Res simu= 0.015812

Déterminer la loi d'une VA $X$ telle que: $$X(\Omega)=\N^*,\quad \exists k\in ]0,1[,\,\forall n\in \N^*,\quad P(X=n)=kP(X\geq n).$$

D'après la condition vérifiée par $X$, on a

$$

P(X=1)=kP(X\geq 1)=k\dsum_{j=1}^\infty P(X=j)=k,\quad \left(\text{ car } (X\geq

1)=\bigcup_{j\geq 1} (X=j)\right).

$$

Essayons de calculer $P(X=2)$,

$$P(X=2)=kP(X\geq 2)=k\dsum_{j\geq 2}P(X=j)=k\left(\dsum_{j\geq

1}P(X=j)-P(X=1)\right)=k(1-k).$$

Maintenant, calculons $P(X=3)$,

$$\begin{array}{lcl}

P(X=3)&=&kP(X\geq 3)=k\dsum_{j\geq 3}P(X=j)=k\left(\dsum_{j\geq

1}P(X=j)-P(X=1)-P(X=2)\right)\\

&=&k\left(1-k-k(1-k)\right)=k(1-k)^2.

\end{array}$$

On peut alors mettre l'hypothèse suivante: Pour tout $n\in \N^*$,

$P(X=n)=k(1-k)^{n-1}$.

Pour $n=1$ l'hypothèse est vérifiée. Soit $n\in \N^*$, supposons que l'hypothèse est vraie

pour tout $k\in \inter{1,n}$ et essayons de la montrer pour $n+1$,

$$\begin{array}{lcl}

P(X=n+1)&=&kP(X\geq n+1)= k\dsum_{j=n+1}^\infty P(X=j)\\

&=&k\left(\dsum_{j=1}^\infty P(X=j)-\dsum_{j=1}^nP(X=j)\right) =k\left(1-\dsum_{j=1}^n

k(1-k)^{j-1}\right)\\

&=&k\left(1-k\dfrac{1-(1-k)^n}{1-(1-k)}\right)=k(1-k)^n

\end{array}$$

On en déduit que la relation est vérifiée au rang $n+1$, ce qui termine la démonstration.

En particulier, pour tout événement $A\in \mathcal{F}$, on a $P(A)=\dsum_{n\in

I}P((X=x_n)\cap A)$.

Soit $X$ une v.a.d tel que $X(\Omega)=\{2,4,6,8\}$. On suppose que $$P(X=8)=\dfrac{1}{2},\quad P(X=2)=P(X=4),\quad P(X\in \{2,4\})=\dfrac{1}{3}.$$ On note $a=P(X=2),\,b=P(X=4),\,c=P(X=6)$ alors on a $$a=b,\quad a+b=\dfrac{1}{3},\quad a+b+c+\dfrac{1}{2}=1\Longrightarrow a=b=\dfrac{1}{6}=c.$$ Donc on peut donner la loi de $X$ sous la forme

| Valeur de $X$ | $2$ | $4$ | $6$ | $8$ |

| Probabilité | $\dfrac{1}{6}$ | $\dfrac{1}{6}$ | $\dfrac{1}{6}$ | $\dfrac{1}{2}$ |

Pour $n\in \N^*$, on note $p_n=\dfrac{1}{n(n+1)}$. Montrer que $(p_n)_{n\in \N^*}$ est la loi de probabilité d'une V.A.D $X$.

Pour tout $n\in \N^*$, on a $p_n\geq 0$ et la série $\dsum p_n $ est convergente, de plus $$\forall N>0,\, \dsum_{n=1}^Np_n=\dsum_{n=1}^N\dfrac{1}{n(n+1)}=\dsum_{n=1}^N\dfrac{1}{n}-\dfrac{1}{n+1}=1-\dfrac{1}{N+1}\tendvers{N}{\infty}1.$$ Donc il existe une V.A.D $X$ tel que $X(\Omega)=\N^*$ et $P(X=n)=p_n$.

Trouver la fonction de répartition pour la VAD X définie dans l’exercice précédent.

Il est clair que si $x< 1$ alors $P(X\leq x)=0$, puis pour $x\geq 1$ on a $$P(X\leq x)=P(X\in ]-\infty,x])=\bigcup_{k\in \N^*,\, k\leq x} P(x=\{k\})=\dsum_{k=1}^{\mathrm{E}(x)}\dfrac{1}{k(k+1)}=1-\dfrac{1}{E(x)+1}.$$

- La fonction $F_X$ est croissante sur $\R$,

- $\limiteX{x}{\infty}F_X(x)=1,\quad \limiteX{x}{-\infty}F_X(x)=0.$

- $F_X$ est continue à droite en tout point.

Lois usuelles

On note

- Une variable uniforme ne peut qu'un nombre fini de valeurs possibles.

- Si $A\subset X(\Omega)$ alors $P(X\in A)=\dfrac{\sharp (A)}{\sharp (\Omega)}$.

- La loi uniforme modélise par exemple le résultat d'un lancer de dé équilibré.

On note

$X\hookrightarrow \Bb(p)$ mesure le succès d'une expérience, $(X=1)$ si c'est un succès et $(X=0)$ si c'est un échec. Les cas $p=0$ ou $p=1$ ne représentent aucune intérêt, donc on suppose en générale $p\in ]0,1[$.

Le nombre $S$ de succès lors d'une succession de $n$ épreuves de Bernoulli de paramètre $p$ mutuellement indépendantes suit la loi binomiale de paramètres $n$ et $p$. En effet, la variable aléatoire $S$ est à valeurs dans $\inter{0,n}$ et, pour $k\in \inter{0,n}$, l'événement $(S = k)$ est la réunion des événements consistants à fixer $k$ succès et $n -k$ échecs. Ces événements sont deux à deux incompatibles, sont au nombre de ${n\choose k}$, et chacun est de probabilité $p^k (1 - p)^{n-k}$ par indépendance mutuelle. On a donc $$P(S = k) = {n \choose k}p^k(1-p)^{n-k}.$$

Soit $X$ une VA, on suppose que $X\hookrightarrow \Bb(n,p)$ et on pose $Y=n-X$. Donner la loi de $Y$.

$$P(Y=k)=P(n-X=k)=P(X=n-k)= {n \choose n-k}p^{n-k}(1-p)^{n-(n-k)}$$ Après simplification, on trouve, $$\forall k\in \inter{0,n},\,P(Y=k)={n \choose k}(1-p)^{k}(1-(1-p))^{n-k}\Longrightarrow Y\hookrightarrow \Bb(n,1-p).$$

On répète indéfiniment le lancer d'un dé équilibré à 6 faces.

Soit $X$ la variable aléatoire donnant la valeur du rang d'apparition du premier 6.

Donner la loi de $X$.

Il est clair que $P(X=0)=0$. Notons $A_n$: " 6 sort au $n$ième lancer ". Alors, pour $n\in \N^*$, on a $(X=n)=\overline{A_1}\cap \cdots \cap \overline{A_{n-1}}\cap A_n$. Puisque les événement $A_n$ sont incompatibles, on en déduit $$\forall n\geq 1,\,P(X=n)= P(\overline{A_1}\cap \cdots \cap \overline{A_{n-1}}\cap A_n) =P(\overline{A_1})\cdots P(\overline{A_{n-1}})P(A_n)=(\dfrac{5}{6})^{n-1}\dfrac{1}{6}.$$ On trouve finalement que $X\hookrightarrow \mathcal{G}(1/6)$.

Une ligne de métro compte 4 arrêts. Le train met une minute pour aller d'une station à

l'autre et s'y arrête

pendant un temps négligeable.

Un voyageur fatigué monte à la station $0$ au temps $t=0$ et s'endort; la VA $T$ associée au

temps qu'il met à se

réveiller suit une loi géométrique

Trouver la loi suivi par $X$, VA représentant le numéro de la station où il se réveille.

On suppose (puisque la question ne très précise!) que la ligne de métro est fermé

i.e. on passe

de la station n°3 à la station n° 0.

L'événement $(X=0)$ peut s'écrire comme $\dsp \bigcup_{k\in \N^*} (T=4k)$, Donc

$$\begin{array}{lcl}

P(X=0)&=&\dsum_{k\geq 1}p(1-p)^{4k-1}=\dfrac{p}{1-p}\dsum_{k\geq 1}(1-p)^{4k}\\

&=&\dfrac{p}{1-p}\left(-1+\dfrac{1}{1-(1-p)^4}\right)=\dfrac{p(1-p)^3}{1-(1-p)^4}.

\end{array}$$

De même,

$$\begin{array}{lcl}

P(X=1)&=&\dsum_{k\in \N}p(1-p)^{(4k+1)-1}=\dfrac{p}{1-(1-p)^4}\\

P(X=2)&=&\dsum_{k\in \N}p(1-p)^{(4k+2)-1}=\dfrac{p(1-p)}{1-(1-p)^4}\\

P(X=3)&=&\dsum_{k\in \N}p(1-p)^{(4k+3)-1}=\dfrac{p(1-p)^2}{1-(1-p)^4}\\

\end{array}$$

Si on suppose que $p=0.65$, on obtient,

$$P(X=0)\simeq 0.0283,\,P(X=1)\simeq 0.6599,\,P(X=2)\simeq 0.231,\,P(X=3)\simeq 0.0808.$$

Les propriétés suivantes sont équivalentes :

- Il existe $p \in ]0,1[$ tel que $X \hookrightarrow\mathcal{G}(p)$.

- $P(X = 1) > 0$, $P(X > n) > 0$ pour tout $n \in \N$ et $$\forall (n,k) \in \N^2, \quad P(X > n + k \mid X > n) = P(X > k).$$

La loi d'une variable aléatoire vérifiant 2 est dite

On définit bien une loi, en effet, pour tout $k\in \N$, $P(X=k)\geq 0$ de plus $\dsum_{n\in \N}P(X=k)=1$.

La loi de Poisson intervient généralement lorsque on compte le nombre d’occurrences d’un événement dans un intervalle de temps donné, par exemple le nombre de clients d’un magasin pendant une journée, le nombre de voitures prenant une autoroute pendant une heure....

- Pour tout $n\in \N,\,\,X_n\hookrightarrow\Bb(n,p_n)$

- $\dsp np_n\tendversN \lambda$.

Alors, pour tout $k\in \N,\quad \dsp P(X_n=k)\tendversN\ee^{-\lambda}\dfrac{\lambda^k}{k!}$.

Dans la pratique on utilise la loi de Poisson pour approcher la loi binomial. i.e. estimer

le nombre de fois où un événement se réalise pendant un temps donné

En générale, on estime que l'approximation est satisfaisante si $n\geq 30$ et $p\leq 0.1$.

Couples de variables aléatoires discrètes

Si $Z$ est une v.a.d, on dit que le couple

L'événement $Z=(x,y)$ est souvent noté $(X=x,Y=y)$.

La réciproque n'est pas vrai i.e.les lois marginales de $Z$ ne suffisent pas pour déterminer la loi de $Z$.

Soient $X$ et $Y$ deux variables aléatoires définies sur un même espace probabilisé $(\Omega, \mathcal{F}, P)$ et à valeurs dans $\N$. On suppose que la loi du couple $(X; Y )$ est donnée par : $$\forall (i; j) \in \N^2,~~ P((X = i) \cap (Y = j)) = \dfrac{1}{\ee 2^{i+1}j!}.$$ Déterminer les lois de $X$ et de $Y$.

Soit $k\in \N$, on a $(X=k)=\dsp\bigcup_{j\in \N}(X=k\cap Y=j)$ ce qui donne $$P(X=k)=\dsum_{j=0}^\infty \dfrac{1}{\ee 2^{k+1}j!}=\dfrac{1}{\ee 2^{k+1}}\dsum_{j\geq 0}\dfrac{1}{j!}=\dfrac{1}{2^{k+1}}.$$ De même, on trouve $$\forall k\in \N,~~ P(Y=k)=\dfrac{1}{k!\,\ee}.$$

- La loi conditionnelle de $X$ sachant $(Y=y)$ est la loi de $X$ dans l'espace probabilisé $(\Omega,\mathcal{F},P_{(Y=y)})$.

- De la même façon, si $x\in X(\Omega)$ tel que $P(X=x)>0$, on peut définir la loi conditionnelle de $Y$ sachant $(X=x)$

Si $X,Y$ sont indépendantes alors la loi conjointe du couple $(X,Y)$ est le produit des lois marginales.

Soit $X$ et $Y$ deux variables aléatoires discrètes indépendantes. On suppose que $X$ et $Y$ suivent des lois de Poisson de paramètres $\lambda $ et $\mu $. Quelle est la loi suivie par $X + Y$~?

Soit $n\in \N$, on a $(X+Y=n)=\dsp\bigcup_{k=0}^n (X=k\cup Y=n-k)$, donc $$\begin{array}{lcl} P(X+Y=n)&=&\dsum_{k=0}^nP(X=k)P(Y=n-k)=\dsum_{k=0}^n\dfrac{\ee^{-\lambda}\lambda^k}{k!}\dfrac{\ee^{-\mu}\mu^{n-k}}{(n-k)!}\\ &=&\dfrac{\ee^{-\lambda}\ee^{-\mu}}{n!}\dsum_{k=0}^n\dfrac{n!}{k!(n-k)!}\lambda^k\mu^{n-k}= \ee^{-(\lambda+\mu)}\dfrac{(\lambda+\mu)^n}{n!} \end{array}$$ On en déduit que $X+Y\hookrightarrow \mathcal{P}(\lambda+\mu)$.

Soit $X$ et $Y$ deux variables aléatoires indépendantes suivant des lois de Poisson de paramètres $\lambda $ et $\mu $. Reconnaître la loi de $X$ sachant $X + Y = n$.

Soit $k\in \N$ avec $k\leq n$, on a (en utilisant le faite que $X$ et $Y$ sont indépendantes), $$P_{(X+Y=n)}(X=k)=\dfrac{P(X=k \cap X+Y=n)}{P(X+Y=n)}=\dfrac{P(X=k)P(Y=n-k)}{P(X+Y=n)}.$$ Or $$P(X+Y=n)=\dsum_{k=0}^nP(X=k)P(Y=n-k)=\dsum_{k=0}^n\dfrac{\ee^{-\lambda}\lambda^k}{k!}\dfrac{\ee^{-\mu}\mu^{n-k}}{(n-k)!}=\ee^{-(\lambda+\mu)}\dfrac{(\lambda+\mu)^n}{n!} $$ On en déduit, pour tout $n\in \N$, $$P_{(X+Y=n)}(X=n)=\dfrac{\ee^{-\lambda}\lambda^k\ee^{-\mu}\mu^{n-k}}{k!(n-k)!}\dfrac{n!}{\ee^{-(\lambda+\mu)}(\lambda+\mu)^n}={n\choose k}\left(\dfrac{\lambda}{\lambda+\mu}\right)^k\left(\dfrac{\mu}{\lambda+\mu}\right)^{n-k}.$$ En notant $p=\dfrac{\lambda}{\lambda+\mu}$ donc $1-p=\dfrac{\mu}{\lambda+\mu}$, on reconnaît une loi binomiale de paramètres $n$ et $p$.

$X$ et $Y$ désignent deux variables aléatoires discrètes à valeurs dans $\N$ et indépendantes.

- Montrer que $P(X=Y)=\dsum_{k=0}^\infty P(X=k)P(Y=k)$.

On suppose à partir de maintenant que $X\hookrightarrow \mathcal{P}(\lambda)$ avec $\lambda>0$ et qu'il existe $p\in ]0; 1[$ tel que, pour tout $k\in \N, P (Y = k) = p(1 - p)^k$. On considère la matrice aléatoire $A=\begin{pmatrix} X&X+Y\\0&Y \end{pmatrix}$.

- Calculer la probabilité que $A$ ne soit pas inversible.

- Préciser la loi de la variable aléatoire $\rg (A)$ (qui donne le rang de la matrice $A$) ainsi que son espérance.

- Donner une condition nécessaire et suffisante sur $a; b$ et $c$ pour qu'une matrice de $\MM_2(\R)$; de la forme $\begin{pmatrix} a& c\\ 0& b \end{pmatrix}$ soit diagonalisable.

- Calculer la probabilité que $A$ soit diagonalisable.

- L'événement $(X=Y)$ s'écrit sous la forme $\dsp\bigcup_{k\in \N}(X=k)\cap (Y=k)$ et vu que ces événement sont incompatibles et que $X,\,Y$ sont indépendants, on en déduit, $$P(X=Y)=\dsum_{k=0}^\infty P((X=k)\cap (Y=k))=\dsum_{k=0}^\infty P(X=k)P(Y=k).$$

- $A$ n'est pas inversible ssi $X=0$ ou $Y=0$, donc $$\begin{array}{lcl} P(A \text{ n'est pas inversible})&=& P((X=0)\cup (Y=0))\\ &=&P(X=0)+P(Y=0)-P((X=0)\cap (Y=0))\\ &=&P(X=0)+P(Y=0)-P(X=0)P(Y=0)\\ &=&\ee^{-\lambda}+ p-p\ee^{-\lambda}. \end{array}$$

-

Comme $A$ est de taille 2, alors les possibilité de rang de $A$ sont 0,1 et 2.

- $\rg(A)=2$ si $A$ est inversible, donc $$P(\rg (A)=2)=1-P(A \text{ n'est pas inversible}) =1-(\ee^{-\lambda}+ p-p\ee^{-\lambda}).$$

- $\rg(A)=0$ ssi $A=0$ donc $X=Y=0$ $$P(\rg (A)=0)=P((X=0)\cap (Y=0))=P(X=0)P(Y=0)=p\ee^{-\lambda}.$$

- Enfin $\rg (A) =1$ ssi $\rg(A)\not\in \{0,2\}$, donc $$P(\rg (A)=1)=1-P(\rg(A)\in \{0,2\})=1-p\ee^{-\lambda}-(1-(\ee^{-\lambda}+ p-p\ee^{-\lambda}))= \ee^{-\lambda}+p-2p\ee^{-\lambda}.$$

- D'après le cours d'algèbre, on a $A$ est diagonalisable ssi ($a\neq b$) ou ($a=b$ et $c=0$).

On répète $n$ fois une expérience aléatoire et on note $X_i$ le résultat de la $i$ième expérience ($i\in \inter{1,n}$). Si on suppose que le résultat d'une expérience n'a pas d'influence sur les autres, alors il est usuel de supposer que les variables $X_1,\cdots,X_n$ sont mutuellement indépendantes.

Une famille de $n$ v.a.d deux à deux indépendantes n'est pas forcement une famille mutuellement indépendantes.

On lance deux dé, et on note $X, \,Y$ les parité de chaque dé et $Z$ la parité de la somme. Alors les variables $X, Y,Z$ sont deux à deux indépendantes, mais pas mutuellement indépendantes.

L'hypothèse mutuellement indépendantes est indispensable comme le montre l'exemple précédant.

Soient $X_1,X_2,X_3,X_4$ des v.a.d réelles mutuellement indépendantes, alors $X=X_1+X_2$ et $Y=X_4+\ee^{X_2}$ sont indépendante

Moments d'une variable aléatoire discrète

Si $X(\Omega)$ est fini alors $X$ admet un moment d'ordre $r$ pour tout $r\geq 1$.

Espéranc

On dit que

Si $X(\Omega)$ est fini alors $X$ admet une espérance.

Si $X$ est le résultat d'une expérience aléatoire, on pourrait imaginer que $E(X)$ (s'il existe) la valeur que l'on s'attend à trouver, en moyenne, si l'on répète un grand nombre de fois la même expérience aléatoire.

On donne $X$ une VA telle que $X(\Omega)=\N^*$ et $P(X=k)=\dfrac{\alpha}{k(k+1)(k+2)}$.

- Déterminer la valeur de $\alpha$.

- $X$ admet une espérance? $\xcancel{une\, variance}$? Si oui, la (les ) calculer.

-

D'abord il faut que $\alpha$ soit $\geq 0$, car $P(X=k)\geq 0$, ensuite il faut

que

$\dsum_{k=1}^\infty P(X=k)=1$.

Pour calculer cette somme, on écrit, pout $k\geq 1$, $$\dfrac{1}{k(k+1)(k+2)}=\dfrac{A}{k}+\dfrac{B}{k+1}+\dfrac{C}{k+2}=\dfrac{1/2}{k}+\dfrac{-1}{k+1}+\dfrac{1/2}{k+2},$$ Soit $N\geq 1$, on a $$\begin{array}{lcl} \dsum_{k=1}^N \dfrac{a}{k(k+1)(k+2)}&=&\dsum_{k=1}^N \left(\dfrac{a/2}{k}+\dfrac{-a}{k+1}+\dfrac{a/2}{k+2}\right)\\ &=&\dfrac{a}{2} \dsum_{k=1}^N \left(\dfrac{1}{k}-\dfrac{1}{k+1}\right)-\dfrac{a}{2}\dsum_{k=1}^N \left(\dfrac{1}{k+1}-\dfrac{1}{k+2}\right)\\ &=&\dfrac{a}{2}\left(1-\dfrac{1}{N+1}\right)-\dfrac{a}{2}\left(\dfrac{1}{2}-\dfrac{1}{N+2}\right)\tendvers{N}{\infty}\dfrac{a}{4}\Longrightarrow\boxed{ a=4}. \end{array}$$ -

$kP(X=k)\underset{k\to \infty}{\sim}\dfrac{4}{k^2}$, comme $\dsum\dfrac{1}{k^2}$

converge, on en déduit que $\dsum kP(X=k)$ converge, donc $X$ admet une

espérance

De plus, pour tout $N\geq 1$, on a $$\begin{array}{lcl} \dsum_{k=1}^N kP(X=k)&=&\dsum_{k=1}^N \left(\dfrac{4}{(k+1)(k+2)}\right)=4 \dsum_{k=1}^N \left(\dfrac{1}{k+1}-\dfrac{1}{k+2}\right)\\ &=&4\left(\dfrac{1}{2}-\dfrac{1}{N+2}\right)\tendvers{N}{\infty}2\Longrightarrow\boxed{ E(X)=2}. \end{array}$$ $k^2P(X=k)\underset{k\to \infty}{\sim}\dfrac{4}{k}$, comme $\dsum\dfrac{1}{k}$ diverge, on en déduit que $\dsum k^2P(X=k)$ diverge, donc $X$ n'admet pas une variance.

- Si $X\hookrightarrow \Bb(p)$ alors $X$ admet une espérance finie et $E(X)=p$.

- Si $X\hookrightarrow \Bb(n,p)$ alors $X$ admet une espérance finie et $E(X)=np$.

- Si $X\hookrightarrow \mathcal{G}(p)$ alors $X$ admet une espérance finie et $E(X)=\dfrac{1}{p}$.

- Si $X\hookrightarrow \mathcal{P}(\lambda)$ alors $X$ admet une espérance finie et $E(X)=\lambda$.

Dans l'exercice lancers de dé, $X$ suit une loi géométrique de paramètre $p=1/6$. Donc $X$ admet une espérance fini égale à $1/p=6$. Ce qui signifie qu'en moyenne, on obtiendra le premier 6 après 6 lancers.

Dans ce cas, on a $E(f(X))=\dsp\dsum_{n\in I}f(x_n)P(X=x_n)$.

C'est un théorème très important et très pratique. En effet, ceci permet de calculer l'espérance de $f(X)$ (sous réserve d'existence) sans calculer la loi de $f(X)$.

Soit $X$ une VAD suivant la loi de Poisson de paramètre $\lambda>0$. Calculer $E\left(\frac{1}{1+X}\right)$.

On pose $f(x)=\dfrac{1}{1+x}$, d'après le théorème du transfert, $f(X)$ admet une

espérance ssi $\dsum f(n)P(X=n)$ converge i.e. $\dsum

\dfrac{1}{1+n}\dfrac{\ee^{-\lambda}\lambda^n}{n!}$ converge, or cette série est

absolument convergent puisque $\dfrac{1}{1+n}\dfrac{\ee^{-\lambda}\lambda^n}{n!}\leq

\dfrac{\ee^{-\lambda}\lambda^n}{n!}$

On en déduit alors que $f(X)$ admet une espérance et,

$$E(f(X))=\dsum_{n\geq 0}\dfrac{\ee^{-\lambda}\lambda^n}{(n+1)\times

n!}=\ee^{-\lambda}\dsum_{n\geq

1}\dfrac{\lambda^{n-1}}{n!}=\dfrac{\ee^{-\lambda}}{\lambda}\left(\dsum_{n\geq

0}\dfrac{\lambda^{n}}{n!} -1\right)$$

Après un calcul qui a mobilisé nos connaissance sur les séries entières , on trouve

$$\boxed{E\left(\frac{1}{1+X}\right)=\dfrac{1-\ee^{-\lambda}}{\lambda}}.$$

Soit $X$ une variable aléatoire suivant une loi géométrique de paramètre $p$. Calculer $E\left( {\frac{1}{X}} \right)$.

Rappelons que, pour tout $x\in ]-1,1[$, on a $$\dfrac{1}{1-x}=\dsum_{k=0}^\infty x^k,\quad -\ln(1-x)=\dsum_{k=0}^\infty \dfrac{x^{k+1}}{k+1}=\dsum_{k\geq 1}\dfrac{x^k}{k}.$$ En utilisant la formule de transfert, on a $$E\left(\frac{1}{X}\right)=\dsum_{k\geq 1}\dfrac{1}{k}p(1-p)^{k-1}=\dfrac{p}{(1-p)}\dsum_{k\geq 1}\dfrac{(1-p)^k}{k}=\dfrac{-p\ln(1-(1-p))}{1-p}=\dfrac{-p\ln(p)}{1-p}.$$

-

$aX+Y$ est d'espérance finie et l'on a $E(aX+Y)=aE(X)+E(Y)$ (

Linéarité de l'espérance )

Donc l'ensemble des v.a.d d'espérance fini sur $(\Omega,\mathcal{F},P)$ est $\R$-espace vectoriel et l'espérance est une forme linéaire. On notera dans la suite $$\mathcal{V}^1(\Omega,\mathcal{F},P)=\{X \mathrm{v.a.d},\, E(X)< \infty\}.$$ -

Si $X\geq 0$ (ou $P(X\leq 0)=0$) alors $E(X)\geq 0$ (

Positivité de l'espérance ). -

Si $X\leq Y$ (ou $P(X\leq Y)=0$) alors $E(X)\leq E(Y)$ (

Croissance de l'espérance ).

Soient $X$ et $Y$ deux variables aléatoires indépendantes géométriques de paramètres $p$ et $q$. Calculer l'espérance de $Z = \max (X,Y)$.

On suppose que $p,q\in ]0,1[$, soit $n\in \N^*$, on a $$(Z=n)=\left((X=n) \cap (Y< n)\right) \cup \left( (X< n) \cap (Y=n)\right) \cup \left(X=n \cap Y=n\right).$$ En utilisant l'indépendance de $X$ et $Y$, on trouve: $$\begin{array}{lcl} P(Z=n)&=&P(X=n)\dsum_{k=1}^{n-1}P(Y=k)+P(Y=n)\dsum_{k=1}^{n-1}P(X=k)+P(X=n)P(Y=n)\\ &=&p(1-p)^{n-1}\left(1-(1-q)^{n-1}\right)+q(1-q)^{n-1}\left(1-(1-p)^{n-1}\right)\\ &&+pq(1-p)^{n-1}(1-q)^{n-1}\\ &=&p(1-p)^{n-1}+q(1-q)^{n-1}-(p+q-pq)\left(1-(p+q-pq)\right)^{n-1} \end{array}$$ En notant $W$ la VAD t.q $W\hookrightarrow \mathcal{G}(p+q-pq)$, on trouve: $$E(Z)=E(X)+E(Y)-E(W)=\dfrac{1}{p}+\dfrac{1}{q}-\dfrac{1}{p+q-pq}.$$

En particulier, une v.a.d réelle bornée admet une espérance finie.

Dans ce cas, on a $E(X)=\dsum_{n\geq 0}P(X> n)$.

C'est une question qui est tombée à plusieurs reprise dans les oraux, de plus la démonstration est très intéressante car permet de se rappeler les manipulations sur les séries numériques.

Variance

Lorsque $X$ admet une variance, on appelle

La variance et l'écart-type sont des indications de la dispersion de $X$ autour de sa

valeur moyenne

L'écart-type est de même unité que celle des $x_i$.

Ce résultat est cohérent avec l'interprétation de la variance et l'écart-type comme indication de la dispersion de $X$ autour de sa valeur moyenne.

- Si $X\hookrightarrow \Bb(p)$ alors $X$ admet une variance et $V(X)=p(1-p)$.

- Si $X\hookrightarrow \Bb(n,p)$ alors $X$ admet une variance et $V(X)=np(1-p)$.

- Si $X\hookrightarrow \mathcal{G}(p)$ alors $X$ admet une variance et $V(X)=\dfrac{1-p}{p^2}$.

- Si $X\hookrightarrow \mathcal{P}(\lambda)$ alors $X$ admet une variance et $V(X)=\lambda$.

On suppose que le nombre de pièces sortant d'une usine donnée en une journée est une variable aléatoire d'espérance 50.

- Peut-on estimer la probabilité que la production de demain dépasse 75 pièces ?

- Que peut-on dire de plus sur cette probabilité si on sait que l'écart type de la production quotidienne est de 5 pièces ?

- D'après l'inégalité de Markov $$P(X\geq 75)\leq \dfrac{E(X)}{75}=\frac{2}{3}.$$

- En utilisant l'inégalité de Bienaymé-Tchebychev, $$P(\abs{X-50}\geq 25)\leq \dfrac{V(X)}{25^2}=\dfrac{1}{25}=0,004$$ On en déduit $P(X\geq 75)\leq 0,004.$

Covariance

$$\begin{array}{lcl} V(X+Y)&=&E\left( (X+Y)^2\right)-E(X+Y)^2\\ &=& E(X^2)+2E(XY)+E(Y^2)-(E(X)^2+2E(X)E(Y)+E(Y)^2)\\ &=&E(X^2)-E(X)^2+E(Y^2)-E(Y)^2+2(E(XY)-E(X)E(Y))\\ &=&V(X)+V(Y)-2\mathrm{Cov}(X,Y) \end{array}$$ Si on note $\mathcal{V}^2=\{X\in \mathcal{V}^1,\, E(X^2)< \infty\}$, alors $\mathcal{V}^2$ est un s-e-v de $\mathcal{V}^1$, de plus, $$\fonct{\mathrm{Cov}}{\mathcal{V}^2\times\mathcal{V}^2}{\R}{(X,Y)}{\mathrm{Cov}(X,Y)}$$ est une forme bilinéaire (symétrique).

En particulier, dans ce cas on a $V(X+Y)=V(X)+V(Y)$. \\Plus généralement, si $X_1,\cdots,X_n$ sont $n$ VAD réelles admettant toutes un moment d'ordre 2 et indépendantes 2 à 2, alors $V\left(\dsum_{i=1}^nX_i\right)=\dsum_{i=1}^nV(X_i)$.

Soit $X$ une VAD tel que $X(\Omega)=\{-1,0,1\}$ et $P(X=-1)=P(X=0)=P(X=1)=1/3$. On pose $Y=X^2$.

- Calculer $E(X),\,E(Y),\,E(XY)$.

- $X,\,Y$ sont indépendantes?

-

On a $E(X)= -1\times\dfrac{1}{3}+0\times\dfrac{1}{3}+\dfrac{1}{3}=0$.

$Y(\Omega)=\{0,1\}$ et $(Y=0)=(X=0),\, (Y=1)=(X=-1)\cup (X=1)$. On en déduit, $$P(Y=0)=P(X=0)=\dfrac{1}{3},\,P(Y=1)= 1-P(Y=0)=\dfrac{2}{3}\Longrightarrow E(Y)=\dfrac{2}{3}$$ Pour calculer $E(XY)$ il suffit de remarque que $XY=X^3 =X$ puisque $X$ ne prend que des valeurs $\alpha$ tel que $\alpha=\alpha^3$. On en déduit, $$E(XY)=0=E(X)E(Y) \Longrightarrow \mathrm{Cov}(X,Y)=0.$$ - $P((Y=1)\cap (X=1))=P(X=1)=\dfrac{1}{3}$ tandis que $P(X=1)P(Y=1)=\dfrac{1}{3}\dfrac{2}{3}=\dfrac{2}{9}$. On en déduit que $X$ et $Y$ ne sont pas indépendantes.

L'exercice précédent montre que la réciproque de résultat précedent est fausse.

Soient $(X_i)_{1\leq i\leq n}$, $n\,$ VAD mutuellement indépendantes suivants toutes la

même loi et admettant une

variance $K$. Pour $i\in \inter{1,n}$, on pose $Y_i=\dsum_{k=1}^iX_i$.

Expliciter $M=\left(\mathrm{Cov}(Y_i,Y_j)\right)_{i,j\in \inter{1,n}}$ et l'exprimer en

fonction de $A=\begin{pmatrix}

1&\cdots&1\\

&\ddots&\\

0&&1

\end{pmatrix}$. Proposer un encadrement de valeurs propres de $M$.

Soit $(i,j)\in \inter{1,n}^2$, on suppose que $j\geq i$, en utilisant la bilinéarité de la covariance, on trouve: $$\mathrm{Cov}(Y_i,Y_j)= \mathrm{Cov}(\dsum_{k=1}^iX_k,\dsum_{s=1}^jX_s)=\dsum_{k=1}^i\dsum_{s=1}^j\mathrm{Cov}(X_k,X_s)=\dsum_{k=1}^i\dsum_{s=1}^j \delta_{k,\,s}\mathrm{Cov}(X_k,X_s)$$ Autrement dit, avec l'hypothèse $j\geq i$, $\mathrm{Cov}(Y_i,Y_j)=i\mathrm{Cov}(X,X)=iK$, donc $M$ est de la forme $$M=K\begin{pmatrix} 1&1&1&1&\cdots&1&1\\ 1&2&2&2& &&2\\ 1&2&3&3& &&3\\ 1 &2 &3 &4& & &4\\ & & & & \ddots & &\vdots\\ \vdots & & & \vdots & & n-1&n-1\\ 1&2&3&4 & \cdots &n-1&n \end{pmatrix}=K\, ( {\,}^t A \, A)$$ La matrice $M$ étant symétrique, donc diagonalisable. Notons $\Sp (A)=\{\lambda_1,\cdots,\lambda_n\}$. Soit $k\in \inter{1,n}$ et $Z_k={\,}^t (\alpha_1,\cdots,\alpha_n)\in \R^n$ un vecteur propre associé à $\lambda_k$ (donc $Z_k\neq 0$, et quitte à diviser $Z_k$ par une constante, on peut supposer que $\norme{Z_k}_2=1)$. On a alors, $$MZ_k=\lambda_kZ_k\Longrightarrow K{\,}^t A AZ_k =\lambda_kZ_k\Longrightarrow {\,}^t Z_k{\,}^t A_kAZ_k=\dfrac{\lambda_k}{K}{\,}^t Z_kZ_k$$ Autrement dit, $\norme{AZ_k}^2=\dfrac{\lambda_k}{K}$ ce qui montre que $\lambda_k>0$, d'autre part, $$AZ_k=\begin{pmatrix} \alpha_1+\alpha_2+\cdots+\alpha_n\\ \alpha_2+\cdots+\alpha_n\\ \vdots\\ \alpha_{n-1}+\alpha_n\\ \alpha_n \end{pmatrix}\Longrightarrow \norme{AZ_k}^2\leq \max_{i\in \inter{1,n}}(\abs{\alpha_i})\dsum_{j=1}^nj^2\leq \dfrac{n(n+1)(2n+1)}{6}$$ Donc $\lambda_k\leq \dfrac{K}{6}(2n^3+3n^2+n)$.

Fonctions génératrices

Définition

- $R_X\geq 1$, et $G_X$ est continue au moins sur $[-1,1]$, et $G_X(1)=1$.

- Pour tout $n\in \N$, $P(X=n)=\dfrac{G_X^{(n)}(0)}{n!}$.

- Pour tout $t\in ]-R_X,R_X[$, $G_X(t)=E(t^X)$.

- Si $X\hookrightarrow \Bb(p)$ alors $R_X=\infty$ et, pour tout $t\in \R$, $G_X(t)=(1-p)+pt$.

- Si $X\hookrightarrow \Bb(n,p)$ alors $R_X=\infty$ et, pour tout $t\in \R$, $G_X(t)=((1-p)+pt)^n$.

- Si $X\hookrightarrow \mathcal{G}(p)$ alors $R_X=\dfrac{1}{1-p}$ et, pour tout $t\in ]-R_X,R_X[$, $G_X(t)=\dfrac{pt}{1-(1-p)t}$.

- Si $X\hookrightarrow \mathcal{P}(\lambda)$ alors $R_X=\infty$ et, pour tout $t\in \R$, $G_X(t)=\ee^{\lambda (t-1)}$.

Soient $X$ et $Y$ deux variables aléatoires indépendantes sur un même espace probabilisé ; $X$ suit une loi de Bernoulli de paramètre $p$ et $Y$ une loi de Poisson de paramètre $a$. Soit $Z=XY$.

- Déterminer la loi de $Z$.

- Déterminer l'espérance et la variance de $Z$.

- Déterminer la fonction génératrice de $Z$.

-

Soit $k\in \N$, on distingue deux cas,

- Si $k=0$, alors $(Z=0)=(X=0\text{ et } Y\in \N)\cup (X=1\cap Y=0)$ donc $$P(Z=0)=(1-p)\times 1+ p\times \ee^{-a}\dfrac{a^0}{0!}=(1-p)+p\ee^{-a}.$$

- Si $k>0$, alors $(Z=k)= (X=1\cap Y=k)$ ce qui donne $P(Z=k)=p\ee^{-a}\dfrac{a^k}{k!}.$

- $Z$ admet une espérance finie car $\abs{Z}\leq Y$ et $Y$ a une espérance finie. On utilise la définition de l'espérance $$\mathrm{E}(Z)=\dsum_{k\geq 0}kP(Z=k)=\dsum_{k\geq 1}p\ee^{-a}k\dfrac{a^k}{k!}=pa\ee^{-a}\dsum_{k\geq 0}\dfrac{a^k}{k!}\Longrightarrow\boxed{\mathrm{E}(Z)=pa}.$$ Pour la variance, on calcul, $$\begin{array}{lcl} \mathrm{E}(Z^2)&=&\dsum_{k\geq 0}k^2P(Z=k)=p\ee^{-a}\dsum_{k\geq 1}k\dfrac{a^k}{(k-1)!}\\ &=&p\ee^{-a}(a +\dsum_{k\geq 2}k\dfrac{a^k}{(k-1)!})=p\ee^{-a}(a +\dsum_{k\geq 1}(k+1)\dfrac{a^{k+1}}{(k)!})\\ &=&p\ee^{-a}(a +\dsum_{k\geq 1}\dfrac{a^{k+1}}{(k-1)!}+\dsum_{k\geq 1}\dfrac{a^{k+1}}{k!})=p\ee^{-a}\left(a^2\dsum_{k=0}^\infty\dfrac{a^k}{k!}+a\dsum_{k=0}^\infty\dfrac{a^k}{k!}\right) .\\ &=&pa^2+pa. \end{array}$$ on en déduit alors, $\boxed{V(Z)=E(Z^2)-E(Z)^2=pa^2+pa-p^2a^2}$.

- Le terme générale de la série génératrice de $Z$ est $p\ee^{-a}\dfrac{a^nt^n}{n!}$ ($n>0$) donc il y a convergence pour tout $t\in \R$, et $$\begin{array}{lcl} \forall t\in \R,\,G_Z(t)&=&P(Z=0)+\dsum_{n=1}^\infty P(Z=n)t^n = (1-p)+p\ee^{-a}+\dsum_{n\geq 1}p\ee^{-a}\dfrac{a^nt^n}{n!} \\ &=& (1-p)+ p\ee^{-a}\dsum_{n\geq 0}\dfrac{a^nt^n}{n!} \\ &=&\boxed{1-p +p\ee^{a(t-1)}} \end{array}$$

Liens avec moments

On obtient lorsque $R_X>1$, $E(X)=G_X'(1),\, E(X^2)=G_X'(1)+G_X''(1)$.

- L'espérance de $X$ existe ssi $G_X$ est dérivable en $1$, dans ce cas $E(X)=G_X'(1)$.

- La variance de $X$ existe ssi $G_X$ est deux fois dérivable en $1$, dans ce cas, $$V(X)=G_X'(1)+G_X''(1)-G_X'(1)^2.$$

Reprendre l'exercice précédent et trouvez l'espérance, variance en utilisant $G_Z$.

Nous avons trouvé, $G_Z(t)=1-p+p\ee^{a(t-1)}$, ce qui donne $$G_Z'(t)=pa\ee^{a(t-1)},\,G_Z''(t)=pa^2\ee^{a(t-1)}\Longrightarrow G_Z'(1)=pa,\, G_Z''(1)=pa^2.$$ En appliquant alors les formules du cours, on trouve $$E(Z)=ap,\quad V(Z)=pa+pa^2-(pa)^2.$$

Cas des variables indépendantes

Une urne contient 4 boules numérotées $0,\,1,\,1,\,2$. On effectue $n$ triages avec

remise et on note $S_n$ la somme des numéros tirés.

Donner la loi de $S_n$ et déterminer l'espérance de $S_n$.

Pour $k\in \inter{1,n}$, on note $X_k$ le VAD qui donne le numéro de la $k$ème tirage. Les $(X_k)$ sont indépendantes et suivent la même loi $X$ tel que $$P(X=0)=\dfrac{1}{4},\quad P(X=1)=\dfrac{1}{2},\quad P(X=2)=\dfrac{1}{4}.$$ Il est claire que $S_n=\dsum_{k=1}^n X_k$, on en déduit que $G_{S_n}=\dsp\prod_{k=1}^nG_{X_k}=G_X^n$. Or $$\forall t\in \R,\,G_X(t)=P(X=0)t^0+P(X=1)t+P(X=2)t^2=\left(\frac{1+t}{2}\right)^2$$ ce qui donne, $$G_{S_n}(t)=\left(\frac{1+t}{2}\right)^{2n}=\dfrac{1}{2^{2n}}\dsum_{k=0}^{2n}{2n\choose k}t^k.$$ On en déduit, $$\boxed{\forall k\in \inter{0,2n}\,\quad P(S_n=k)=\dfrac{1}{2^{2n}}{2n\choose k}.}$$ En appliquant le résultat du cours, on trouve $$\boxed{E(S_n)=G_{S_n}'(1)=n.}$$

Soient $X\hookrightarrow \mathcal{P}(a),Y\hookrightarrow \mathcal{P}(a)$ deux v.a.d indépendantes ($a\in \R$). On pose $Z=X+3Y$, déterminer la fonction génératrice de $Z$ puis trouver, de deux manières différentes, l'espérance et la variance de $Z$.

$X$ suit une loi de Poisson de paramètre $a$ donc $G_X$ est définie sur $\R$ et on a

$G_X(t)=\ee^{a(t-1)}$.

Il faut déterminer la fonction génératrice de $3Y$, vu que $P(3Y=n)=0$ si $n$ n'est pas

un multiple de $3$, alors

$$g_{3Y}(t)=\dsum_{k=0}^\infty P(3Y=k)t^k=\dsum_{k\in \N}P(3Y=3k)t^{3k}=\dsum_{k\in

\N}P(Y=k)t^{3k}=g_{Y}(t^3)=\ee^{a(t^3-1)}.$$

Comme $X,\,Y$ sont indépendantes, alors $X,\,3Y$ le sont également, on en déduit que la

fonction génératrice de $Z$ est le produit des deux fonctions génératrices de $X$ et

$3Y$ (qui ont le même rayon de convergence), donc

$$\forall t\in \R,\,g_Z(t)=g_X(t)g_{3Y}(t)=g_X(t)g_Y(t^3)=\ee^{a(t^3+t-2)}.$$

Pour déterminer l'espérance et la variance de $Z$, on a

$$E(Z)=E(X+3Y)=E(X)+3E(Y)=4a,\quad V(Z)=V(X+3Y)=V(X)+9V(Y)=10a.$$

La deuxième méthode consiste à utiliser la fonction génératrice, en effet, comme $g_Z$

est de classe $\CC^\infty$ sur $\R$, alors,

$$E(Z)=g_Z'(1),\,V(Z)=g_Z''(1)+g_Z'(1)-g_Z'(1)^2.$$

Or,

$$\forall t\in

\R,\,g_Z'(t)=a(3t^2+1)\ee^{a(t^3+t-2)},\,g_Z''(t)=(6at+a^2(t^2+1)^2)\ee^{a(t^3+t-2)},$$

Donc $ g_Z'(1)=4a,\,g_Z''(1)=16a^2+4a.$ En remplaçant dans les formules ci-dessus, on

trouve $$E(Z)=4a,\,\,V(Z)=16a^2+6a+4a-(4a)^2=10a.$$

Soient $X$ et $Y$ deux variables aléatoires indépendantes et de même loi. Soit $Z$ une variable aléatoire suivant une loi géométrique de paramètre $p$ telle que $Z=X+Y+1$.

- Trouver l'espérance et la variance de $X$.

- Calculer $G_X(t)$.

- Trouver la loi de $X$.

-

Comme $X,Y$ suivent la même loi, alors (sous réserve d'existence) ils ont la

même espérance et variance.

D'autre part, $X+Y=Z-1$ a une espérance et variance finie, on en déduit que

$e=\mathrm{E}(X)= \mathrm{E}(Y)< \infty$ et $v=\mathrm{V}(X)=\mathrm{V}(Y)<

\infty$,

- En utilisant la linéarité de l'espérance, on trouve: $$2e=\mathrm{E}(Z-1)=\mathrm{E}(Z)-\mathrm{E}(1)=\dfrac{1}{p}-1\Longrightarrow\boxed{ e =\dfrac{1-p}{2p}}.$$

- En utilisant la définition de la variance et le faite que $X$ et $Y$ sont indépendantes, on trouve: $$2v=\mathrm{V}(Z-1)=\mathrm{V}(Z)-\mathrm{V}(1)=\dfrac{1-p}{p^2}-0\Longrightarrow\boxed{ v =\dfrac{1-p}{2p^2}}.$$

- Comme $X$ et $Y$ sont indépendantes, alors $G_{X+Y}(t)=G_X(t)^2$, or $$\begin{array}{lcl} G_{X+Y}(t)&=&G_{Z-1}(t)=\dsum_{k=0}^\infty P(Z-1=k)t^k\\ &=&\dsum_{k=0}^\infty P(Z=k+1)t^k=\dsum_{k=0}^\infty p(1-p)^kt^k=\dfrac{p}{1-(1-p)t}\\ &&\Longrightarrow\boxed{G_X(t)=\sqrt{\dfrac{p}{1-(1-p)t}}}. \end{array}$$ Le rayon de convergence de $G_X$ est alors $\dfrac{1}{1-p}$.

- D'après le cours sur les séries entières, on a $\dsp \forall x\in ]-1,1[,\,\dfrac{1}{\sqrt{1-x}}=\dsum_{n=0}^\infty\dfrac{(2n)!}{2^{2n}(n!)^2}x^n$, donc $$\forall x\in ]-1/(1-p),1/(1-p)[,\,\dfrac{\sqrt{p}}{\sqrt{1-(1-p)x}}=\dsum_{n=0}^\infty\dfrac{\sqrt{p}(2n)!}{2^{2n}(n!)^2}(1-p)^nx^n.$$ On en déduit, $\boxed{P(X=n)=\dfrac{\sqrt{p}(2n)!(1-p)^n}{2^{2n}(n!)^2}}$.

Si $X\hookrightarrow \Bb(n,p)$ ($n\in \N^*,\,p\in ]0,1[$) alors on peut écrire

$X=\dsum_{k=1}^nX_i$ avec $X_i\hookrightarrow \Bb(p)$

Comme $X_i\hookrightarrow \Bb(p)$ alors $G_{X_i}(t)=(1-p)+pt$, pour tout $t\in \R$, en

utilisant le résultat précédent, on trouve que $X$ admet une fonction génératrice

définie sur $\R$, de plus,

$$\forall t\in \R,\quad G_X(t)=\prod_{i=1}^nG_{X_i}(t)=(1-p+pt)^n.$$

Soient deux dés (pipés ou non) indépendants. Montrer qu'il est impossible d'obtenir la loi uniforme pour la somme S des deux dés (c'est-à-dire $P(S=i)=\dfrac{1}{11}$ pour tout $i\in \inter{2,12}$.

Notons $X_1$ (resp. $X_2$) le v.a.d qui donne le résultat de 1ère dé (resp. de 2

ème dé), et

$$\forall i\in \inter{1,6},\quad P(X_1=i)=\alpha_i,\quad P(X_2=i)=\beta_i$$

Bien évidement si les dés ne sont pas pipés on aura

$\alpha_i=\beta_i=\dfrac{1}{6}$.

Donc $S=X_1+X_2$, supposons que $S$ suit une loi uniforme, alors on aurait

$$\forall t\in

\R,\,G_S(t)=\dsum_{k=2}^{12}\dfrac{t^k}{11}=\dfrac{t^2}{11}\left(1+t+\cdots+

t^{10}\right)= G_{X_1}(t)G_{X_2}(t).$$

D'autre part,

$$G_{X_1}(t)=t\left(\alpha_1+\alpha_2 t+\cdots+\alpha_6 t^5\right)= t\varphi_1(t)$$

$$G_{X_2}(t)=t\left(\beta_1+\beta_2 t+\cdots+\beta_6 t^5\right)= t\varphi_2(t)$$

avec $\varphi_1,\,\varphi_2$ deux polynômes de degrés 5 (et exactement

5---justifier!)

On en déduit

$$\forall t\in \R,\, \left(1+t+\cdots+ t^{10}\right)= 11\varphi_1(t)\varphi_2(t)$$

ce qui est absurde car $t\longmapsto \left(1+t+\cdots+ t^{10}\right)$ n'admet pas de

racines réelles, tandis que $\varphi_1\varphi_2$ a au moins une racine réelle.

Loi faible des grands nombres

On suppose que les $X_i$ sont indépendantes, de même loi, possédant une espérance $m=E(X)$

et une variance $\sigma^2=V(X)$

On pose

$$\overline{X}_n=\dfrac{1}{n}\left(X_1+X_2+\cdots+X_n\right)=\dfrac{\dsum_{i=1}^nX_i}{n}.$$

Alors,

$$\forall \varepsilon >0,\quad P\left(\abs{\overline{X}_n-m}\geq \varepsilon\right)\leq

\dfrac{\sigma^2}{n\varepsilon^2}.$$

et,

$$\forall \varepsilon >0,\quad P\left(\abs{\overline{X}_n-m}\geq

\varepsilon\right)\tendversN\,0.$$

Ce théorème permet permet d'interpréter l'espérance comme une moyenne.

Soit $(X_n)_{n\geq 1}$ une suite de variables aléatoires deux à deux indépendantes. On suppose que chaque $X_n$ suit une loi de Bernoulli de paramètre $p_n$. On note $S_n=X_1+\dots+X_n$ et on souhaite démontrer que, $$ \forall \varepsilon>0, \lim_{n\to+\infty}P\left(\left|\frac {S_n}n-\frac 1n\sum_{k=1}^n p_k\right|\geq \varepsilon\right)=0.$$

- Pourquoi ne peut-on pas appliquer directement la loi faible des grands nombres?

- Quelle est l'espérance de $S_n$? Sa variance? Démontrer que $V(S_n)\leq n$.

- En déduire le résultat.

- Pour pouvoir appliquer la loi faible des grands nombres, il faut que les v.a.d $X_n$ ont la même espérance, or ce n'est pas le cas ici (sauf si on suppose que $p_1=\cdots=p_n$).

- Comme $X_k\hookrightarrow \Bb(p_k)$, alors $E(X_k)=p_k$ et $V(X_k)=p_k(1-p_k)$, on en déduit alors, $$E(S_n)=\dsum_{k=1}^nE(X_k)=\dsum_{k=1}^pp_k,\cdots V(S_n)=\dsum_{k=1}^nV(X_k)=\dsum_{k=1}^np_k(1-p_k)\leq n.$$

- On note $Y=\dfrac{S_n}{n}$, alors $Y$ admet une espérance et une variance, et on a $$E(Y)=\dfrac{1}{n}E(S_n)=\dfrac{1}{n}\dsum_{k=1}^np_k,\quad V(Y)=\dfrac{1}{n^2}V(S_n)\leq \dfrac{1}{n}.$$ On applique ensuite l'inégalité de Bienaymé-Tchebychev. Ce qui donne, $$\forall \varepsilon>0,\,P(\abs{Y-E(Y)}\geq \varepsilon)=P\left(\abs{\dfrac{S_n}{n}-\dfrac{1}{n}\dsum_{k=1}^np_k}\geq \varepsilon\right)\leq \dfrac{V(Y)}{\varepsilon^2}\leq \dfrac{1}{n\varepsilon^2}.$$ $\varepsilon$ étant fixé, donc $\dfrac{1}{n\varepsilon^2}\tendversN\,0$, d'autre part, $P\geq 0$, donc en utilisant le théorème d'encadrement on obtient le résultat.

Soit $(X_n)$ une suite de variables aléatoires mutuellement indépendantes suivant la même loi de Bernoulli de paramètre $p \in ]0, 1[$. On note pour tout $n$ dans $\N^*$ : $ Y_n =\dfrac{X_n+X_{n+1}}{2},\quad S_n=\dsum_{i=1}^nY_i.$

- Calculer $E(S_n),\,V(S_n)$.

- Montrer que, pour tout $\varepsilon>0$, $P\left(\abs{\frac{S_n}{n}-p}\geq \varepsilon\right)\tendversN\,0$.

- Soit $n\geq 1$, on a $$\begin{array}{lcl} S_n&=&Y_1+Y_2+\cdots+Y_{n-1}+Y_n\\ &=&\dfrac{1}{2}\left(X_1+X_2+X_2+X_3+\cdots+ X_{n-1}+X_n+X_n+X_{n+1}\right)\\ &=&\dfrac{1}{2}\left(X_1+X_{n+1}\right)+\dsum_{k=2}^nX_k. \end{array}$$ Par linéarité de l'espérance, on obtient, $$E(S_n)=\dfrac{1}{2}\left(E(X_1)+E(X_{n+1})\right)+\dsum_{k=2}^nE(X_k)=p+(n-1)p=p.$$ De même, on a $$V(S_n)=\dfrac{1}{4}\left(V(X_1)+V(X_{n+1}\right)+\dsum_{k=2}^nV(X_k)=\dfrac{4n-2}{4}(p(1-p)).$$

- On applique le théorème de Bienaymé-Tchebychev à $Z_n=\dfrac{S_n}{n}$, ce qui donne $$0\leq P\left(\abs{Z_n-E(Z_n)}\geq \varepsilon\right)= P\left(\abs{\frac{S_n}{n}-p}\geq \varepsilon\right)\leq \dfrac{V(Z_n)}{\varepsilon^2}=\dfrac{(4n-2)p(1-p)}{4n^2\varepsilon^2}$$

Soit $(X_n)$ une suite de variables aléatoires mutuellement indépendantes suivant la même loi de Bernoulli de paramètre $p \in ]0, 1[$. On note pour tout $n$ dans $\N^*$ : $$S_n =\dfrac{X_1+\cdots+X_n}{n},\quad Y_n =\dfrac{X_n+X_{n+1}}{2},\quad T_n=\dfrac{Y_1+\cdots+Y_n}{n}.$$

- Montrer que, pour tout $\varepsilon>0$, on a $P\left(\abs{S_n-p}\geq \varepsilon\right)\tendversN\,0$.

- Déterminer pour tout $n \in \N^*$ la loi et l'espérance de $Y_n$ ; pour $m < n$, $Y_m$ et $Y_n$ sont-elles indépendantes?

- Montrer que, pour tout $\varepsilon>0$, $P\left(\abs{T_n-p}\geq \varepsilon\right)\tendversN\,0$.

- Application direct du cours.

-

Il est clair que si $\abs{n-m}\geq 2$ alors $Y_n,\,Y_m$ sont indépendants

Par contre si $m=n+1$, alors $Y_n,\,Y_{n+1}$ ne sont pas indépendantes, en effet,- $P(Y_{n+1}=0)=P(X_{n+1}=0\cap X_{n+2}=0)=(1-p)^2$, et $P(Y_n=1)=P(X_n=1\cap X_{n+1}=1)=p^2$, donc $$P(Y_{n+1}=0)P(Y_n=1)=p^2(1-p)^2$$

- D'autre part, $$P((Y_{n+1}=0)\cap (Y_n=1))=P(((X_{n+2}=0) \cap (X_{n+1}=0))\cap ((X_{n+1}=1) \cap (X_{n}=1))$$ donc $P((Y_{n+1}=0)\cap (Y_n=1))=0$ puisque $(X_{n+1}=1) \cap (X_{n+1}=0)= \emptyset$.

- Voir exercice précédent.